이어서 정리한 joint representation에 대한 논문 정리입니다.

Abstract

- 해당 논문은 싱글 그리고 멀티모달의 다르지만 관련있는 카테고리의 라벨 데이터에 대한 문제를 다룸

- Jointly learn, Unlabel 데이터에 대한 클러스터를 적용하기 위한 End-to-end 프레임워크를 구현

- 자기지도학습을 사용하여 오버피팅을 방지

- 특히, 클래스분류나 크로스-모달 분류를 사용

- WTA라는 해싱 알고리즘을 사용하여 수도라벨을 생성하였음

Introduction

- 실생활에 딥러닝을 적용하는 것은 많은 문제들을 동반하는데, 이는 클래스 정의하는데 많은 비용이 발생한다는 점과, 새로운 클래스들도 나타나고 있다는 점

- 반대로 생각하면, 실제 세계는 풍부한 멀티모달의 Unlabel 데이터를 생산한다. 이 데이터들은 기계학습을 통해 모델이 사람처럼 학습할 수 있게해줌 (사람이 매일 텍스트, 비디오, 오디오로부터 배우는 것처럼)

- 최근의 활동들은 지식을 전수하는 형태로 ( 라벨 데이터에서 언라벨 데이터로) (최근 활동: Learning to discover visual categories via DL Clustering, Automatically discovering & learning new visual categories with ranking statics)

- 해당 논문에서는 언라벨 데이터들을 Unknown 카테고리에서 적절한 의미가 있는 그룹으로 파티셔닝하는데, 해당 그룹엔 기존의 라벨 데이터들이 존재함

- 이러한 방식은 순수 비지도학습의 클러스팅보다 현실적으로 볼 수 있음

- 이러한 설정은 사람의 인지 과정과 비슷한데 , 사람은 새로운 것에 대한 학습을 기존의 알고 있었던 것에서 전이하여 인지함

- 구체적으로, 해당 논문은 Unlabelled data에 대한 범주를 찾는것을 End-to-End 형식의 프레임워크로 설명하였고,

- labelled data와 Unlabel data 모두 활용하였음

- 위와 같은 두 데이터 활용은 편향되지않는 특징 추출 학습에 사용되었고, 동시에 더 많은 지식을 라벨 데이터에서 언라벨 데이터로 추출하였음

- 특히, 기존의 Contrastive learning을 확장하였는데, (SimCLR, Momentum contrast) 이는 객체 분류와, 라벨 언라벨 데이터간 더 연관되어 있는 특징 추출에 활용하기 위해 고려되었음

- 또한, Representation learning에서 멀티모달 데이터가 Cross-modal 분류에 더 많은 이점이 있는것을 증명하였음

- 언라벨 데이터를 활용하기위해 Winner-Takes-ALL 이라는 해싱 알고리즘을 사용하였고 이는 즉석에서 짝이 일치하는 수도 라벨을 생성하기 위해 사용되었음

- 이렇게 생성되는 라벨은 언라벨에서 라벨 데이터로의 Robust Knowledge transfer에서 핵심으로 사용됨

- Weak Pseduo label을 통해, 모델은 간단한 binary cross-entropy loss를 언라벨 데이터에서 사용하고 standard cross-entropy loss를 라벨 데이터에서 사용함

- 이런 방법으로 모델은 동시에 feature representation을 학습하고 통일된 loss function을 사용해 클러스터링을 구현함

Method

- 주어진 Unlabelled 데이터들을 C개의 다른 의미 그룹으로 파티셔닝하는게 목표

- C개의 Labelled 데이터들도 있다고 가정하며, 해당 데이터에서 지식을 전수해서 Unlabelled data가 적절한 클래스에 그룹될 수 있도록 함

- 각 데이터들은 이미지거나 멀티모달(Visual stream과 Audio stream)

- 해당 그림은 전체적인 과정을 나타냄

- 각각 Visual encoder , Audio Encoder은 두 개의 feature vector로 인코딩함

- 그 후에 두 벡터를 합침 (global reperesentation)

- Projection function은 해당 global representation을 identity mapping function으로 인풋

- Projection function은 identity mapping function (항등 매핑 함수)

- 이러한 Projection function은 global representation을 압축된 representation space로 투영

- 만약 처음에 인풋된 데이터가 라벨 데이터라면, 투영된 벡터들은 라벨데이터 전용 linear head로 보내지고 지도학습에 사용

- 반면 언라벨 데이터는 언라벨데이터 전용 linear head로 보내짐

- 추가로 global representation이전의 벡터들은 hideen layer를 걸쳐 벡터(hat) 을 생성하고, 이들은 contrastive learning을 위해 사용됨

- Hideen layer는 l2 normalization과 함께 사용되는 MLP

- 효과적으로 transfer knowledge하기 위해 WTA(winner takes all) 알고리즘을 projection된 언라벨 데이터 에 사용됨

Unified Contrastive learning on label/unlabel data

- Unknown class를 클러스터링하기 위해 통일된 데이터 (라벨+언라벨)에서 최대한 많은 정보를 많이 뽑는게 중요

- 해당 모델은 라벨 데이터와 언라벨 데이터를 합쳐서 사용하며 이들을 사용해 Contrastive learning을 진행

Multimodal learning

- 멀티모달에선 Cross-modal을 사용하는데, 이는 within-modal 보다 self-supervised 모델에서 더 나은 representation을 나타냄

- 그러나 모델의 셋팅은 라벨데이터와 언라벨 데이터 모두를 사용하기 때문에 객체 분류와 클래스 카테고리 분류 두가지 혼합의 결과를 냄

- 이는 바로 명백하게 어느 modal(within, cross)이 더 효과적인지 알 수 없음

- Embedded representation을 Z^hat 으로, modality 선택 함수를 g로 설정함

- 그렇게 되면 각각 NCE Loss 함수 (Noise Contrastive Estimation)를 Instance discrimination, Category discrimination으로 나타낼 수 있음

- 해당 Loss function을 사용해서 실험을 돌린결과, cross-modal contrastive learning이 더 나은 representation을 만든다고 얻었음

Knowledge transfer via Winner take all hash

- 라벨 데이터를 사용해 언라벨 데이터의 Novel category discovery를 돕기 위해서, Knowledge를 transfer하는데 여기서 사용한 기법이 Winner-Take-All hash 알고리즘임 (WTA)

- WTA는 Sparse embedding method로, feature vector를 integer code로 맵핑해줌

- WTA를 각각의 새로운 카테고리 안 언라벨 데이터 짝의 유사도를 측정하기 위해 사용하였음

- 이 방식으로 라벨 카테고리에서 언라벨 데이터로 Knowledge transfer를 할 수 있음

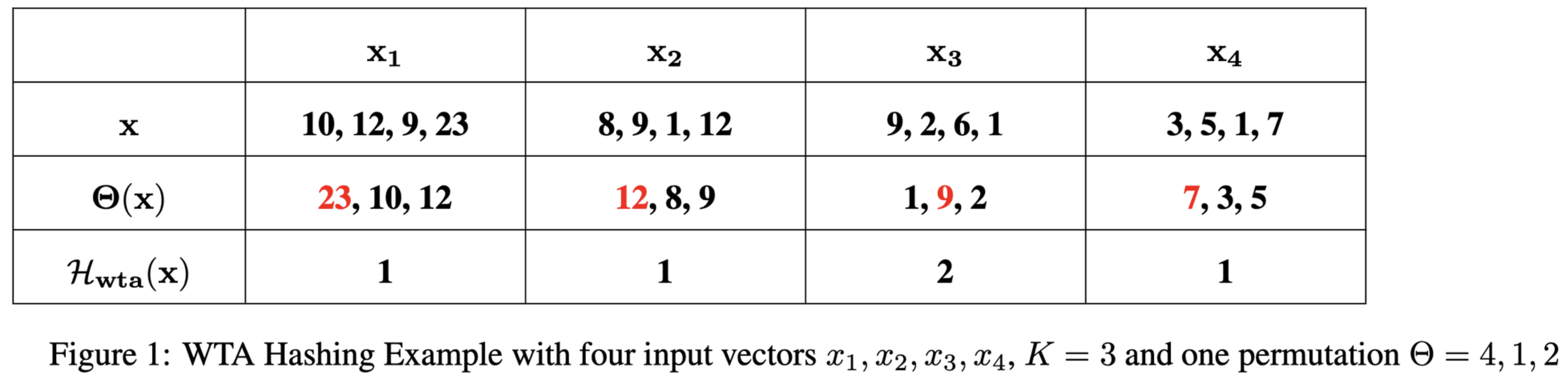

Winner-Take-All hash

- WTA의 아이디어는 고차원 벡터 사이의 유사도를 측정하는데, partial ranking statistics를 사용함

- 여기서 Partial Ranking Statistcs는 랭킹 시스템에서 전체 아이템 집합 중 일부 순위를 나타낸 것임

- 첫번째로 H개의 순열을 랜덤하게 만들고, 추출한 언라벨 데이터의 feature vector를 해당 순열과 같이 나열

- 클래스는 해당 나열의 최댓값 인덱스로 정의하고 Hash code를 해당 인덱스의 모임으로 나타냄

- 사진은 WTA에 대한 논문에서 추출

- #Revisiting Winner Take All (WTA) Hashing for Sparse Datasets

WTA for novel category discovery

- 해당 논문에선 이런 WTA hash code로 유사도를 측정하고(S_ij), 이를 pairwise pseudo label를 생성하는데 사용됨

- Threshold가 정해져 있고, WTA는 오직 학습시에만 시행됨

- 이런 WTA는 실험에서도 확인할 수 있지만, 다른 Pseudo label 생성 대안보다 좋은 효과를 나타냄

- 위 수식을 통해 얻은 Pseudo label들을 사용해 ‘Binary cross-entropy’ loss를 적용

- 이러한 loss는 representation 학습과 언라벨 데이터에 대한 클러스터링을 동시에 학습

- 함수 파이 는 비선형 함수로, feature vector Z를 같은 차원의 embedded space로 투영함 (차원은 softmax를 거친 언라벨 데이터의 클래스 갯수)

- 이런식으로 각각의 언라벨 샘플에 대한 클러스터링을 얻을 수 있음

Joint Learning Objective

- 준지도학습과 비슷하게, 해당 논문은 Consistency regularization loss를 두 라벨/언라벨 데이터에 모두 적용하였음

- 일관성을 위해 데이터 x와 augmentation된 x’ 은 WTA hash code와 상관없이 positive parir로 간주됨

- Consistency loss는 mean squared error로 흔하게 사용되고, 수식은 다음과 같음

- 마찬가지로 파이함수는 input에 따라 달라짐

- 전체적인 training loss는 다음과 같이 나타낼 수 있음

- w함수는 증가 함수로, 0에서 1사이의 천천히 증가. 이 함수는 각 weight으로 사용되는데, Weight으로 사용됨으로써 Early stage에선, 클러스터링은 매우 noisy하지만, 모델이 더 representation learning에 집중하는 것으로 예상하였음

- 따라서 높은 가중치는 Representation learning을, 낮은 가중치는 Consistency를 위해 설정됨

주석 1. Closed-world recognition: 인식해야하는 라벨이 정해져 있고, 이들 중 하나로만 출력하도록 설계. 따라서 이는 새로운 클래스 인식에 부적합

주석 2. Weak Pseudo label: 일반적으로 일부 어노테이션이 부정확하거나 불완전한 상황에서 학습 데이터셋을 보강하는 방법. 이 용어는 주로 반지도 학습(Semi-supervised Learning) 또는 약지도 학습(Weakly-supervised Learning)에서 사용됨.

모델은 먼저 레이블이 있는 데이터를 사용하여 초기 학습을 수행하고, 이 초기 모델을 사용하여 레이블이 없는 데이터에 대한 예측을 생성. 이 예측은 'pseudo labels'이며, 이를 실제 레이블처럼 사용하여 모델을 더 학습시킴

'Weak pseudo labels'은 이 방법의 한 변형으로, 레이블이 있는 데이터가 부족하거나, 레이블 자체가 부정확하거나 불완전한 경우에 사용됨. 이 경우, 모델은 초기 학습을 위해 불완전하거나 부정확한 레이블을 사용하며, 이를 'weak labels'이라고 함

따라서 'weak pseudo labels'는 이러한 'weak labels'을 사용하여 생성된 pseudo labels를 의미함. 이 방법을 통해, 모델은 불완전하거나 부정확한 레이블에도 불구하고 더욱 향상된 성능을 달성 가능!

주석 3. Sparse embedding : (뤼튼 참고)

고차원의 벡터 공간에서 데이터를 표현하는 방법 중 하나로, 벡터의 대부분의 요소가 0인 상태를 가리킴. 이러한 표현 방식은 대부분의 요소가 0이기 때문에 '희소(sparse)'라고함

희소 임베딩은 특히 텍스트, 그래프, 범주형 데이터 등의 복잡한 구조를 가진 데이터를 다룰 때 유용한데, 이러한 데이터는 종종 매우 많은 수의 고유한 값(예: 단어, 노드, 범주 등)을 가지므로, 이를 고차원 벡터로 표현할 때 희소 임베딩이 자주 사용됨

예를 들어, 단어를 표현하는 가장 기본적인 방법 중 하나인 원-핫 인코딩

주석 4. Multiple partial order statistics : System A, System B의 각각 부분적 순위를 매겨서 두 순위를 동시에 고려

주석 4-1 Local rank correlation : 두 변수간 순위관계 측정, 한 변수가 변할때 다른 변수의 순위가 어떻게 ?

따라서 두 개념은 혼합되어 사용될 수 있음

주석 5. Consistency Regularization : Input의 Augmentation을 가해서 나온 새로운 Input을 사용해 얻은 Output이 적게 변해야함(혹은 같게)을 가정으로 regularization 진행

해당 논문까지 읽은 것을 바탕으로 다음번엔 리뷰하려던 Multi-modal 논문에 대해 리뷰할 예정입니다.